인공지능(AI)을 활용한 사이버 보안 사고를 막으려면 AI를 바꿀 게 아니라, 조직 문화와 의사결정 체계 등 인간이 가진 문제를 바꿔야 한다. 제미나이 생성 이미지

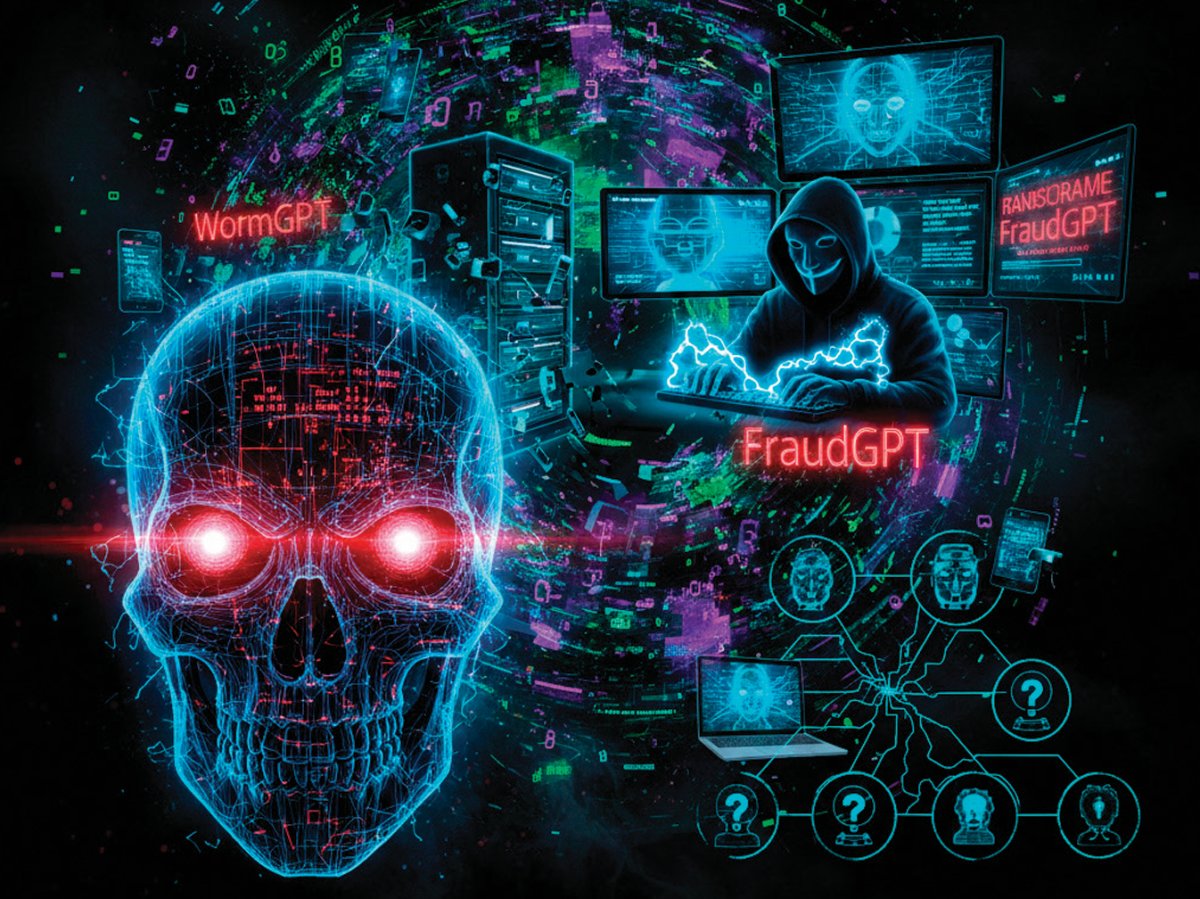

AI 해킹 도구로 빠르고 깊어진 사이버 공격

최근 해킹과 개인정보 침탈 사고가 늘어난 가장 큰 원인은 바로 생성형 인공지능(AI) 발전이다. 챗GPT는 문서나 이미지 생성, 소프트웨어 코딩 등에만 도움을 주는 것이 아니다. ‘WormGPT’ ‘FraudGPT’ 같은 거대언어모델(LLM) 기반 해킹 도구의 탄생과 발전도 부추긴다. 이러한 해킹 도구를 사용하면 전문 해커보다 더 빠르고 깊숙하게 다른 사람의 컴퓨터 시스템에 무단 침입할 수 있다. 또한 해커가 아닌 일반인도 쉽게 해킹 시도가 가능하다. AI 때문에 해킹 공격자가 늘어나고 해킹 속도도 빨라진 것이다.생성형 AI를 기반으로 한 해킹 도구는 구독형 서비스 형태로 누구에게나 열려 있다. 이것들을 사용하면 예전에는 수 시간이 걸리던 피싱 메시지 작성을 몇 분 안에 끝낼 수 있다. 피싱 메시지 내용도 더 교묘하게 쓸 수 있다. 내부 네트워크에 침투한 뒤 권한을 넘겨받고 데이터를 탈취하는 데까지 걸리는 시간도 크게 단축된다.

AI 시대 해킹 사고는 과거와 크게 2가지가 다르다. 먼저 시스템보다 사람을 공격 대상으로 삼는다는 점이다. 2024년 AI 딥페이크 기술을 활용해 상급자의 모습과 목소리로 거짓 지시를 내린 뒤 송금을 유도해 약 2500만 달러(약 342억4000만 원) 피해를 유발한 사례가 대표적이다. 이러한 해킹 유형은 시스템의 취약점보다 인간의 신뢰 구조를 노린다. 이는 보안 사고가 더는 IT(정보기술) 부서만의 문제가 아니라, 조직 문화와 의사결정 체계 전체의 문제라는 것을 의미한다. 보안 설계를 비용으로만 치부하고 보안 관련 규제를 따르는 데만 급급한 조직에서는 구성원이 딥페이크를 활용한 새로운 유형의 해킹 공격을 의심하기 어렵다. 상부 지시를 그대로 따르도록 훈련된 조직은 AI 기반 공격에 취약할 수밖에 없다.

AI 모델 자체를 공격 대상으로 삼을 수 있다는 것도 과거와는 크게 다른 점이다. AI 모델은 사용자가 내린 명령을 해석하고 판단해 결과물을 출력한다. 이 과정에서 단순한 답변 생성을 넘어 사용자 대신 외부 시스템에 연결해 특정 작업을 수행하기도 한다. 문제는 이 과정에서 AI 모델이 어떤 근거와 ’사고 과정‘을 통해 의사결정을 내리는지 파악하기 어렵다는 것이다. 이런 점을 악용해 AI 모델을 교란하고 개인정보를 탈취하는 보안 사고가 일어날 수 있다. 또는 AI 모델을 학습시키는 과정에서 잘못된 데이터를 넣거나, 해서는 안 되는 작업을 강제로 수행하게 하는 등 AI를 혼란스럽게 해 잘못된 결과물을 내놓도록 유도하는 해킹 공격이 발생할 수도 있다.

상부 지시 그대로 따르는 조직 취약

AI 시대 보안 사고도 결국 인간이 만들어낸다는 것은 불변의 진리다. AI는 공격자 의도를 증폭하는 도구일 뿐, 그 도구를 무기화하는 주체는 여전히 인간이다. 사고 본질은 AI가 아니라, 인간의 판단과 통제 실패에 있는 것이다. AI의 유용성에만 함몰돼 보안 문제를 무시한다면 보안 사고를 막을 수 없다. 심지어 AI 해킹 사고 역시 “AI를 도입하면 기술이 알아서 해결해줄 것”이라는 막연한 기대와 착각에 빠진 사람도 많은데, 이는 돌이킬 수 없는 해킹 피해를 자초하는 일일 수 있다.많은 조직이 생성형 AI와 업무 자동화 도구를 빠르게 도입했지만 그 사용 권한과 책임, 데이터 접근 범위, 예외 상황에 대한 통제 규칙 등은 충분히 고민하지 않았다. AI 시대 보안 문제는 더 많은 솔루션을 도입한다고 해결되지 않는다. 개인의 사용 권한과 책임을 명확히 정의하는 것부터 시작해야 한다. 다양한 협업 도구, 생성형 AI 서비스, IoT(사물인터넷) 기기들이 서로 연결된 지금, 개개인의 책임 범위를 명확히 하는 것이 AI 시대 우리의 개인정보와 일상을 지키는 첫걸음이 될 것이다.

![[영상] “미국 증시 상고하저(上高下低), S&P500 7400 전망”](https://dimg.donga.com/a/380/253/95/1/carriage/MAGAZINE/images/weekly_main_top/6968315a05c7d2738e25.jpg)